Что такое интерполяция вообще? Это нахождение промежуточных значений, когда уже известен некоторый набор значений.

Самый простой пример: линейная функция. Прямая на координатной плоскости. Есть значение Y в точке X1, есть другое значение в точке X2. Берём любую точку между X1 и X2 и по уже известным значениям находим искомую величину.

Функции бывают сложнее, но и формулы для интерполяции тоже сложнее.

Как это работает в цифровых изображениях (в том числе фото)?

Картинка представляет собой растр из точек - пикселей. Как тетрадный лист в клеточку. Размер листа - разрешение картинки. У каждой клеточки имеется значение яркости. На самом деле целых три, поскольку используются три цветовых канала, но для данной темы это не важно.

Технический момент. Есть размер светоприёмника (матрицы фотоаппарата). Есть количество датчиков (в итоге - пикселей картинки) в этой матрице. В матрице одной и той же площади может быть различное количество датчиков. Казалось бы, чем их больше, тем чётче картинка: меньше сглаживаются контуры. Но не факт. Чем их больше, тем меньше по размеру каждый отдельно взятый датчик. Тем сложнее свету попасть именно на него. И если света попадает слишком мало, его количество становится сопоставимо с уровнем собственных шумов электроники. И чёткость, равно как и достоверность цвета, падает. Особенно если оптика не даёт картинку такой чёткости, чтобы на соседних датчиках в такой из себя крутой 36-мегапиксельной матрице всегда были отличия.

Разумеется, в технике всё это балансируется под те или иные задачи.

Но необходимо понимать: в зеркалку можно воткнуть матрицу размером 25,1×16,7 мм или вообще полнокадровую 24х36 мм. На ней картинка 10 Мпикс будет гораздо чётче, чем 20 Мпкс на матрице 13,2х8,8 мм в "крутом ультразуме с большой матрицей" и тем более чем 20 Мпикс на "мыльнично-телефонно<wbr />й" матрице формата 1/2.3" (6,3х4,7 мм). Потому что если физически напихать столько датчиков на такую маленькую площадь (если это вообще возможно, а то ведь миниатюризация могла ещё не дойти до таких масштабов), КПД этих датчиков будет ничтожно, а соотношение сигнал-шум - устрашающе.

И вот тут на помощь приходит интерполяция.

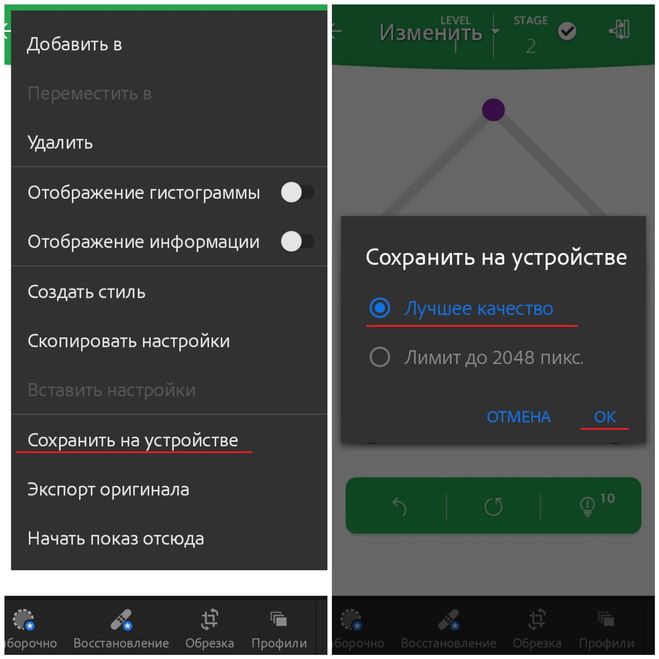

На самом деле в камере какого-нибудь телефона нет столько мегапикселей. Просто при обработке картинка раздвигается. Условно, фотку 10х10 тетрадных клеточек разрежем и раздвинем, добавив по одной клетке между. Сколько получится? Было 10х10, стало 19х19, почти вдвое круче. Эти новые пустые клетки нужно чем-то заполнить. Собственно, тут берутся значения цвета и яркости уже известных клеточек вокруг и по какой-то формуле вычисляется промежуточное значение для клеточки между. И так можно сделать несколько раз, увеличив картинку не в 2 раза, а поболе. Заполнение вычисляется весьма условно и уж точно без учёта контекста, резкость теряется, картинка расплывается (хотя у телефонной "оптики" и мелкой матрицы они изначально не фонтан) - зато разрешение (те самые мегапиксели, то есть миллионы пикселей) возрастает. И можно писать, мол, в этом девайсе просто волшебная камера (!) 16 Мпикс!